A escuta digital e o novo papel da IA nas conversas sobre sofrimento humano

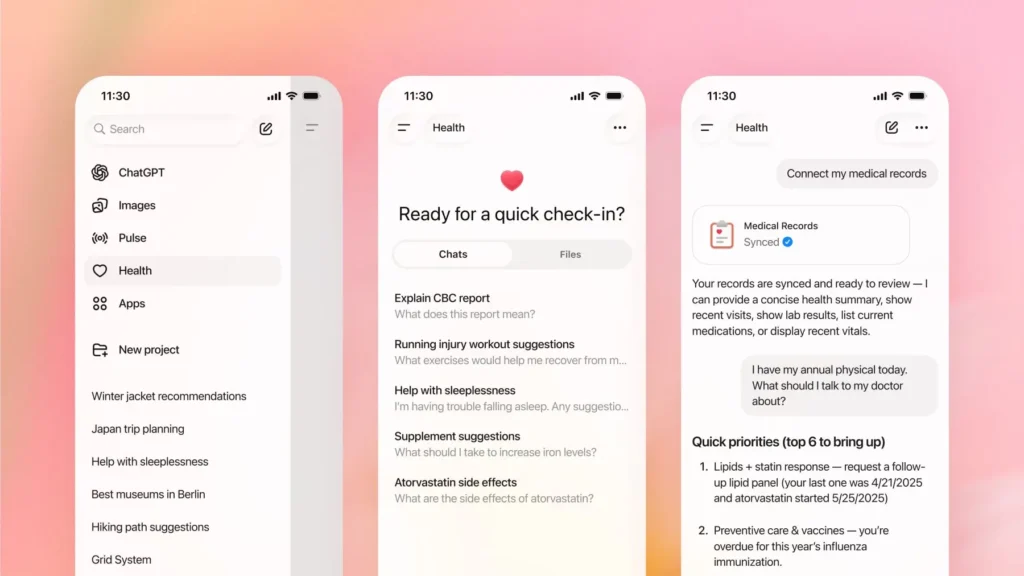

A recente divulgação feita pela OpenAI marca um ponto de virada no debate sobre inteligência artificial e saúde mental. Segundo os dados, cerca de 1,2 milhão de pessoas por semana conversam com o ChatGPT sobre planos de suicídio, e outras 560 mil apresentam sinais compatíveis com psicose ou mania. À primeira vista, os números parecem […]

A recente divulgação feita pela OpenAI marca um ponto de virada no debate sobre inteligência artificial e saúde mental. Segundo os dados, cerca de 1,2 milhão de pessoas por semana conversam com o ChatGPT sobre planos de suicídio, e outras 560 mil apresentam sinais compatíveis com psicose ou mania. À primeira vista, os números parecem percentualmente pequenos, 0,15% e 0,07% dos usuários semanais, mas quando o universo de usuários se conta em centenas de milhões, essas frações representam vidas em escala populacional.

O estudo que acompanha os dados envolveu mais de 170 especialistas em saúde mental, que ajudaram a revisar respostas e protocolos da IA em cenários de crise. O resultado foi expressivo: redução de até 80% nas respostas inseguras, 97% de conformidade em situações graves e mais de 95% de confiabilidade em conversas longas. A tecnologia, portanto, está aprendendo a ouvir com mais cuidado.

Uma mudança de era

A notícia traz à tona um novo conceito, ainda em construção, que começa a ser chamado de “alinhamento clinicamente informado”. A ideia é que o conhecimento clínico passe a orientar o design e a operação das inteligências artificiais, integrando ciência, ética e engenharia de dados. Essa aproximação entre tecnologia e clínica redefine o que significa “treinar um modelo”: não basta torná-lo mais preciso; é preciso torná-lo mais responsável.

O dado da OpenAI não fala apenas sobre IA, fala sobre nós. Mostra que o sofrimento, quando não encontra escuta humana, migra para onde há disponibilidade de resposta. A interface da IA se transforma, assim, em uma porta de entrada para o desespero humano. O que deveria ser uma ferramenta passa a ocupar o lugar simbólico de presença, acolhimento e companhia.

Implicações para empresas e lideranças

Para quem atua com liderança, ESG, saúde mental corporativa ou governança tecnológica, as implicações são diretas. A IA conversacional já não é um assunto apenas técnico: é social e psicológico. Plataformas que interagem com pessoas em contextos vulneráveis assumem, inevitavelmente, responsabilidade de cuidado.

Quando sistemas de IA são usados em programas de bem-estar, escuta ou suporte emocional, é essencial que estejam conectados a redes humanas de apoio. A IA pode auxiliar no monitoramento, na triagem e na orientação, mas não pode, nem deve, substituir a escuta profissional. O risco não está apenas em uma resposta errada, e sim na ilusão de que uma máquina possa, sozinha, oferecer sentido e vínculo.

Além disso, a governança da IA e a governança em saúde mental convergem. As empresas precisam definir protocolos de uso, critérios de supervisão, indicadores de segurança e limites éticos para suas aplicações tecnológicas. Iniciativas desse tipo deixarão de ser diferenciais e passarão a ser exigências de conformidade, sobretudo diante da expansão regulatória que já começa a surgir em países como os Estados Unidos e a União Europeia.

As lacunas que ainda permanecem

Mesmo com os avanços, há questões que exigem prudência. A detecção automática de “intenção suicida” ou “psicose” é uma tarefa complexa, sujeita a erros de interpretação. Uma resposta empática da IA não significa que a pessoa tenha recebido ajuda eficaz. Ainda não há evidência de que a qualidade da resposta digital se traduza em busca de apoio real. E, por outro lado, a dependência emocional das máquinas é um risco crescente, especialmente entre pessoas solitárias, jovens e grupos vulneráveis.

A mensagem central

Se mais de um milhão de pessoas por semana desabafam com uma inteligência artificial sobre temas tão graves, não estamos diante de um fracasso tecnológico, mas de um sinal social. Falta espaço de escuta, falta vínculo, falta presença humana. A IA apenas revela, com dados, o tamanho desse vazio.

A prioridade, daqui em diante, é garantir que a tecnologia amplie a rede de cuidado, e não a substitua. A resposta não está em proibir a IA, mas em desenhá-la com responsabilidade, cercada de protocolos, ética e presença humana. O futuro da inteligência artificial, nesse sentido, é também o futuro da nossa capacidade de continuar humanos em meio à automação.

Matérias relacionadas :

https://www.theguardian.com/technology/2025/oct/27/chatgpt-suicide-self-harm-openai